DeepSeek R1,本地部署才是王道!支持WebUI(最麻烦的Win系统)

DeepSeek R1,本地部署才是王道!支持WebUI(Mac系统)

这是第三个本地安装在乌班图的教程

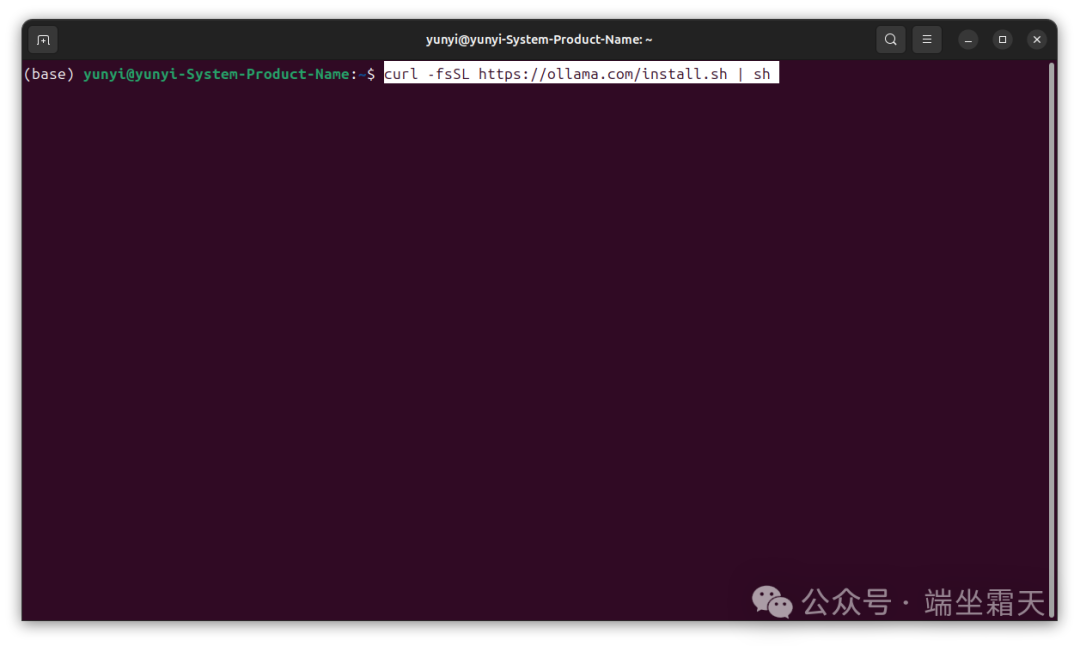

第一步:先下载ollama

https://ollama.com/,选择linux

在“终端”输入以下代码

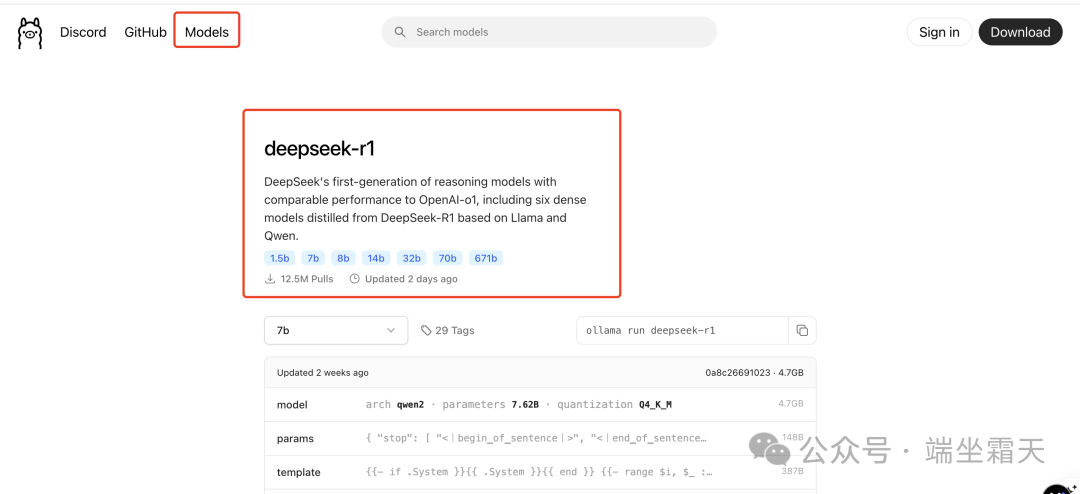

第二步:下载DeepSeek R1模型版

你先看下你的设备适合哪个版本的

我有3个设备安装过

第一台是苹果MACBOOK PRO M1 2020,8GB内存,跑1.5B模型很勉强。

第二台是内存64GB,1050 ti 6gb显存。跑7B模型,速度可以接受。

第三台:128gb内存,4090,24GB显卡,跑32B模型很流畅,70B也可以。461B还没有尝试。

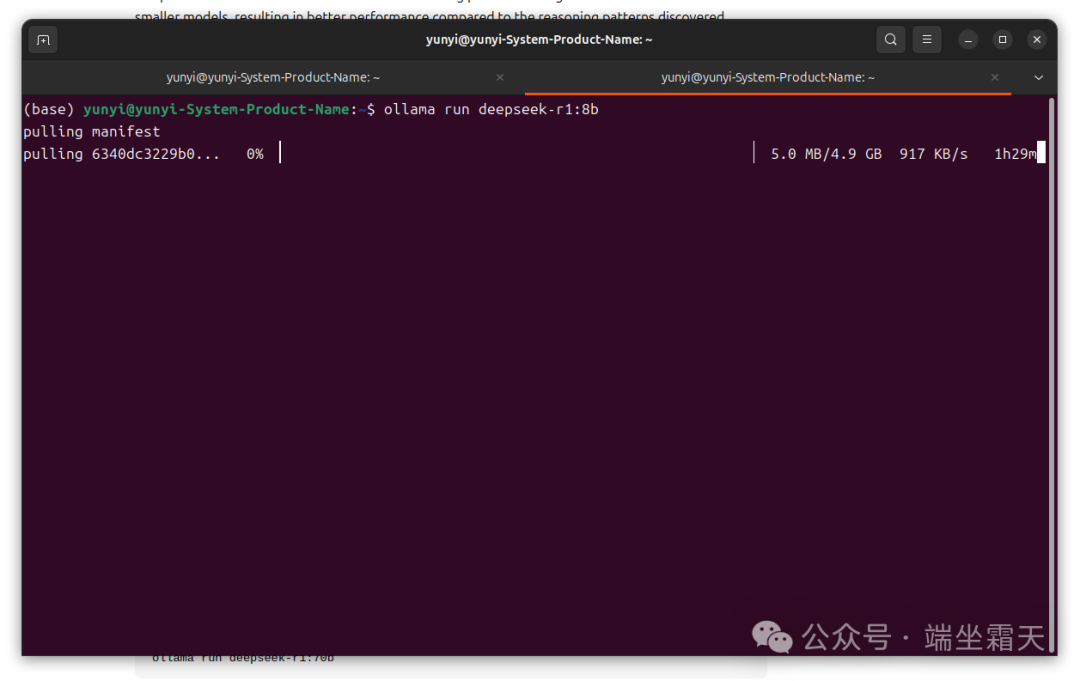

在终端代码输入

如果是8b

ollama run deepseek-r1:8b

在这个过程中,下载速度会越来越慢,如果断了,就重复下deepseek的代码,直到成功为止。

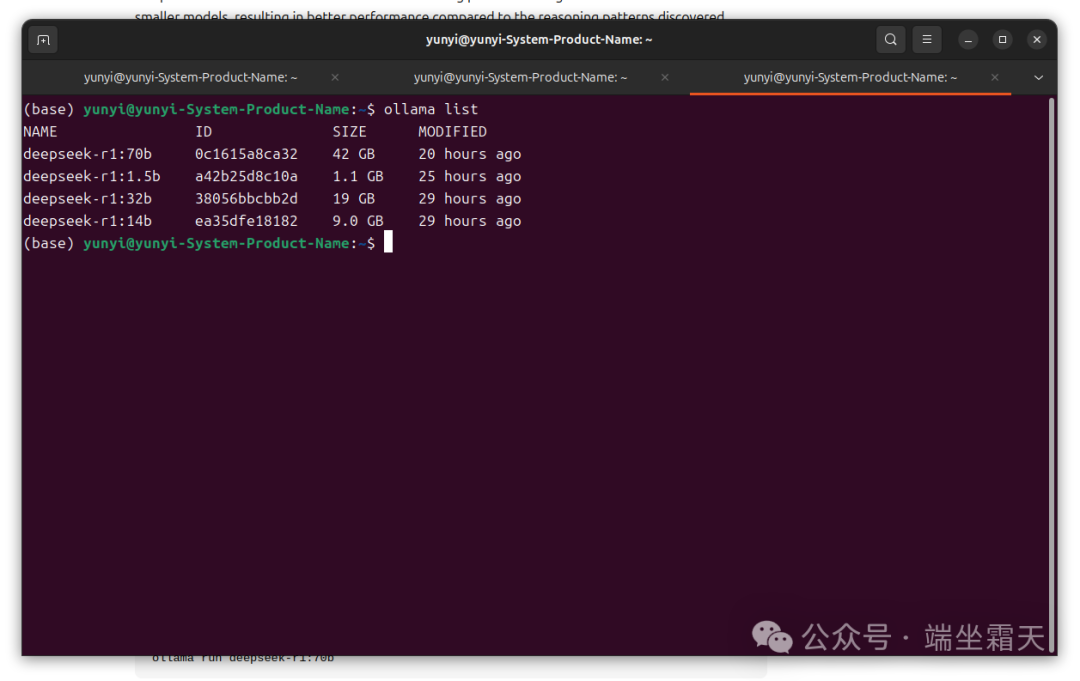

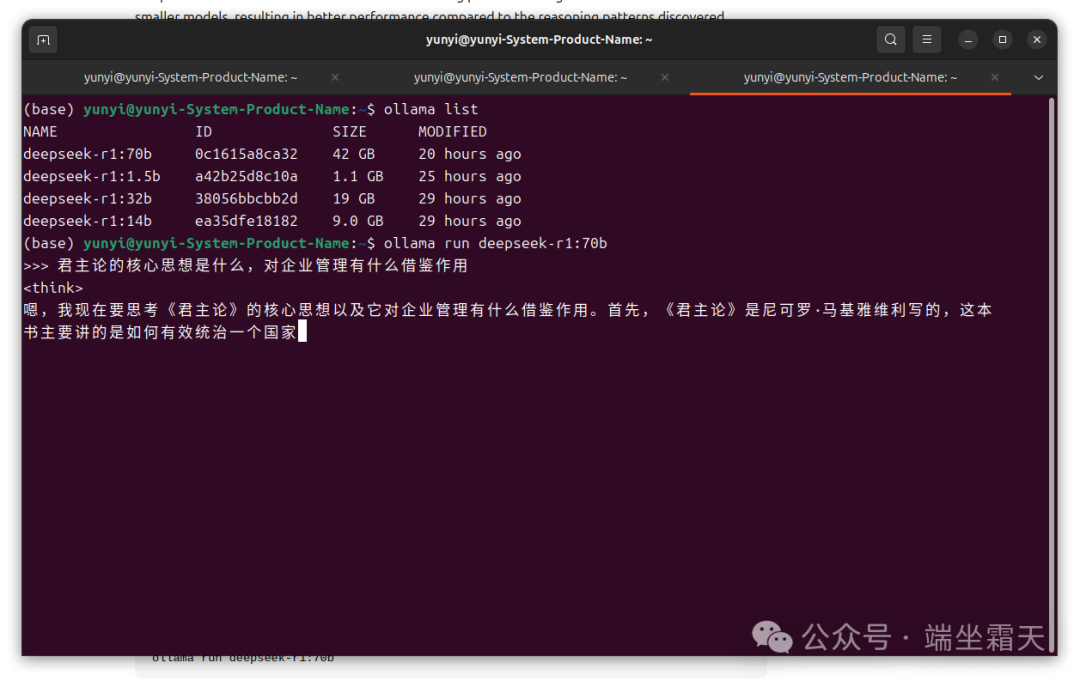

最后检查下有没有安装好,输入:ollama list

就会出现已经在完成的模型,这台电脑上已经下了,1.5b,7b,14b,32b,70b。

安装到这里,deepseek已经完成了,在本地已经可以开始对话了,如果要运行70b,直接输入ollama run deepseek -r1:70b,

第三步:安装docker,和open web ui

但是我们还是希望能有一个界面,那就是openweb ui,在此之前需安装docker

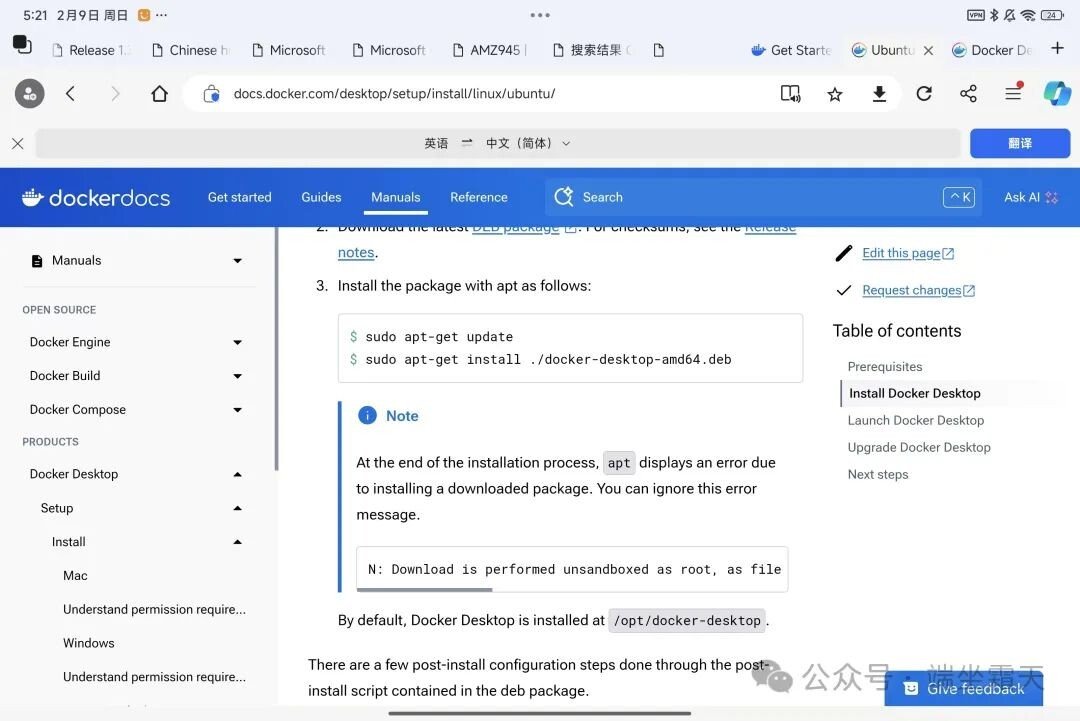

先进入docker.com,选择ubuntu下载,

https://docs.docker.com/desktop/setup/install/linux/ubuntu/

进入到安装指南,根据教程提示一次输入代码

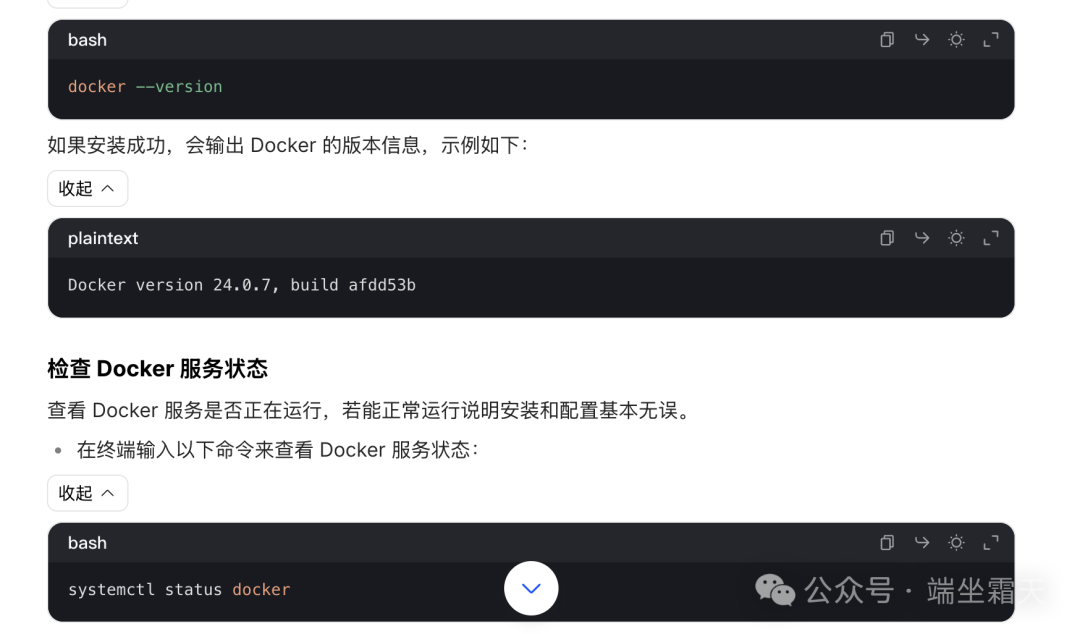

如何确认docker安装成功,请看下以下代码,如果在安装过程中,

遇到报错,请直接把错误代码复制到豆包,或者deepseek询问。

安装OPEN WEBUI:

在github中有专门的说明,进入说明文档复制就就可以

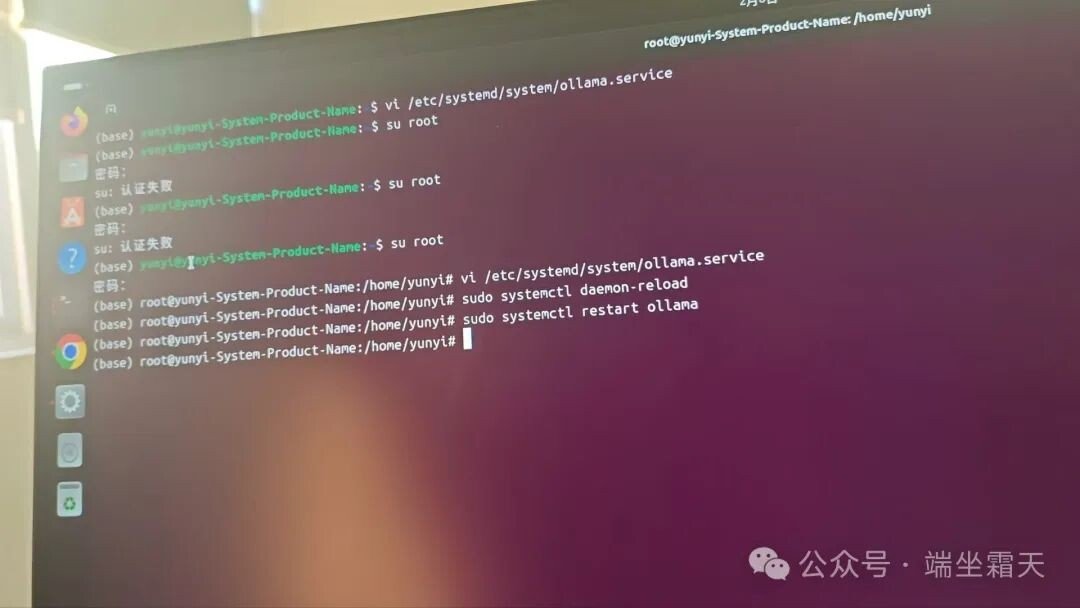

在打开docker的端口:很重要,否则就连接不上,在这一步,我花了一天多的时间,求助鲲鹏哥后,才明白

代码如下:

vi /etc/systemd/system/ollama.service

sudo systemctl daemon-reload

sudo systemctl restart ollama

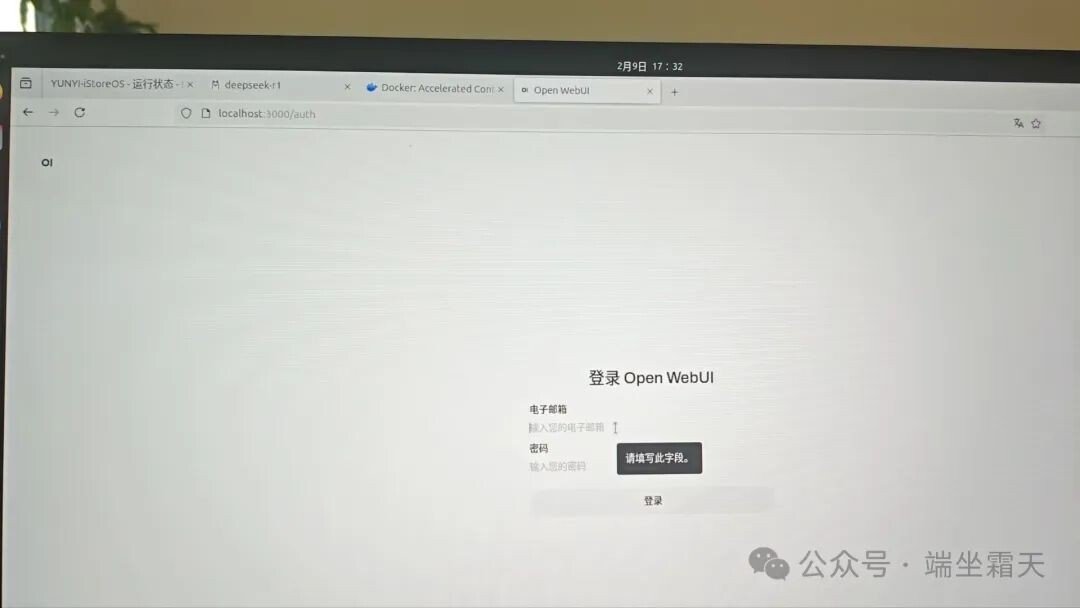

成功后,在浏览器中输入localhost:3000,就进入到openwebui

最后祝大家成功

下面有个群,如果大家对AI有想法,想对工作生活有帮助的话,可以进群

评论